Введение

Что такое конфигурационное управление

Задача управления конфигурацией (configuration management) некоторой системы является типичной для инженерной деятельности. Под конфигурацией понимается состав элементов системы и взаимное их расположение. Конфигурацией можно управлять, отслеживая ее состояние и контролируя целостность изменений конфигурации, а также фиксируя эти изменения в документации.

Можно заметить, что конфигурационное управление в описанном виде представляется достаточно рутинной работой. К счастью, инструменты и подходы, разработанные для конфигурационного управления ПО (software configuration management), позволили автоматизировать многие задачи. Это, в частности, касается популярного инструмента git, который сегодня используется не только программистами, но даже некоторыми художниками и писателями для управления конфигурацией своих творений. Далее под конфигурационным управлением будет пониматься именно конфигурационное управление ПО.

Конфигурационное управление является частью программной инженерии, поэтому к нему применима следующая цитата:

«Программная инженерия – это то, что происходит с программированием при добавлении времени и других программистов» (Russ Cox).

Тематика книги

В этой книге конфигурационное управление трактуется более широко, чем в приведенных выше формальных определениях. Тематика книги в некоторой степени пересекаются с заслуживающими внимания материалами из [1] и [2].

Рассматриваемые далее темы:

- Командная строка.

- Менеджеры пакетов.

- Системы управления версиями.

- Конфигурационные языки.

- Системы автоматизации сборки.

- Виртуальные машины.

- Документация как код.

На рис. 1 приведен граф зависимостей глав книги. Читатель может выбрать собственный порядок изложения тем, не нарушая зависимостей между ними.

Часто можно наблюдать этаких «сапожников без сапог» – программистов, которые решают задачи конечных пользователей, но не занимаются автоматизацией собственных рутинных задач. Поэтому выбор тем книги обусловлен общей целью – стремлением к автоматизации процессов, связанных с разработкой ПО. Акцент на сиюминутных технологиях и инструментах может привести к чрезвычайно быстрому устареванию материала. По этой причине основное внимание в книге уделено общим подходам, алгоритмам и использованию проверенных временем инструментов с открытым кодом.

1.1. Работа в командной строке

1.1. Работа в командной строке

Командная строка на экране монитора – имитация работы с телетайпом. Телетайп, в свою очередь, является электромеханической печатной машиной, которую можно подключить к компьютеру. Пользователь набирает текст, который печатается на рулоне бумаги. Компьютер печатает пользователю свои ответы.

Удивительно, но такой, казалось бы, устаревший способ общения с компьютером все еще активно используется, пусть и с более современными средствами ввода-вывода. Более того, многие задачи очень трудно решить без командной строки! Это касается, в частности, работы с системой контроля версий Git, с системой автоматизации сборки Make, с системой контейнеризации Docker и многими другими популярными сегодня программами. Командная строка в духе UNIX имеется в MacOS, Linux и Windows (WSL, Powershell). Стоит вспомнить и многочисленные фильмы о «хакерах» – если герой фильма решает за компьютером какие-то нетривиальные задачи, то, обычно, зрителю демонстрируется именно командная строка.

Командная строка, как ни странно, хорошо знакома и любителям старых текстовых игр. В этих играх для совершения какого-либо действия необходимо набрать с клавиатуры соответствующую команду в духе go north, read book или take apple.

Вот как выглядит пример диалога с пользователем в игре Zork (1978 г.):

West of House Score: 0 Moves: 4

ZORK

Welcome to ZORK.

Release 13 / Serial number 040826 / Inform v6.14 Library 6/7

West of House

This is an open field west of a white house, with a boarded front door.

There is a small mailbox here.

A rubber mat saying 'Welcome to Zork!' lies by the door.

>open mailbox

You open the mailbox, revealing a small leaflet.

>take leaflet

Taken.

Операционная система UNIX [3] была разработана в далеком 1969 году. UNIX изначально являлась операционной системой в первую очередь для разработчиков, которым удобнее всего автоматизировать свои действия с помощью командной строки. Сама по себе командная строка еще древнее UNIX.

Основная суть решений, принятых при использовании командной строки, сводится к положениям «философии UNIX» (Дуг Макилрой), которые можно выразить следующими пунктами:

- Пусть каждая программа решает одну задачу и решает ее хорошо. Для новых задач создавайте новые программы, а не усложняйте старые новыми «возможностями».

- Предполагайте, что вывод каждой программы может стать входом другой, еще неизвестной программы. Не загромождайте вывод посторонней информацией. Избегайте строго выравненных столбчатых и двоичных входных форматов. Не настаивайте на интерактивном вводе.

- Проектируйте и разрабатывайте ПО, даже операционные системы, таким образом, чтобы его можно было опробовать уже на ранних этапах, в идеале в течение недель. Не бойтесь выбрасывать неудачно реализованные части и пересоздавать их.

- Вместо ручного труда используйте инструменты для облегчения задач разработки, даже если придется отвлечься на создание этих инструментов, а сами инструменты могут впоследствии больше не понадобиться.

Далее будет рассматриваться современный вариант UNIX, популярная ОС Linux, разработанная в 1991 году Линусом Торвальдсом (в то время – студентом финского университета).

При работе с командной строкой необходимо учитывать структуру файловой системы. В Linux она имеет следующий вид:

localhost:~$ tree -d -L 1 /

/

├── bin

├── dev

├── etc

├── home

├── lib

├── media

├── mnt

├── opt

├── proc

├── root

├── run

├── sbin

├── srv

├── sys

├── tmp

├── usr

└── var

Имя / является корнем (root) файловой системы. Внутри корня расположены следующие, наиболее значимые каталоги:

- bin. Исполняемые файлы системных утилит.

- dev. Устройства, к которым в Linux возможен доступ, как к файлам.

- etc. Системные конфигурационные файлы.

- home. Домашние каталоги пользователей.

- lib. Системные библиотеки.

- media. Подключаемые съемные диски: USB, CD-ROM и так далее.

- mnt. Подключаемые разделы.

1.2. Командный интерпретатор

1.2. Командный интерпретатор

За поддержку работы в командной строке отвечает специальная программа – интерпретатор оболочки ОС (shell). В случае Linux таким интерпретатором обычно является Bash, архитектура которого приведена на рис. 2. Под Bash далее будем понимать целое семейство работающих схожим образом интерпретаторов. Интерпретатор выполняет следующие основные действия [4]:

- Принимает строку от пользователя.

- Разбирает эту строку и переводит во внутренний формат.

- Осуществляет подстановку для различных специальных символов и имен.

- Выполняет команду пользователя.

- Выдает код выполнения.

Ниже показан пример сеанса работы в Bash:

localhost:~$ pwd

/root

localhost:~$ ls -l

total 16

-rw-r--r-- 1 root root 114 Jul 5 2020 bench.py

-rw-r--r-- 1 root root 76 Jul 3 2020 hello.c

-rw-r--r-- 1 root root 22 Jun 26 2020 hello.js

-rw-r--r-- 1 root root 151 Jul 5 2020 readme.txt

localhost:~$ echo 'new file' > new_file.txt

localhost:~$ cat new_file.txt

new file

localhost:~$ mkdir new_dir

localhost:~$ cp new_file.txt new_dir/

localhost:~$ rm new_file.txt

localhost:~$ ls -l

total 20

-rw-r--r-- 1 root root 114 Jul 5 2020 bench.py

-rw-r--r-- 1 root root 76 Jul 3 2020 hello.c

-rw-r--r-- 1 root root 22 Jun 26 2020 hello.js

drwxr-xr-x 2 root root 66 Nov 4 17:16 new_dir

-rw-r--r-- 1 root root 151 Jul 5 2020 readme.txt

localhost:~$ ls -l new_dir/

total 4

-rw-r--r-- 1 root root 9 Nov 4 17:16 new_file.txt

Обратите внимание на использование в приведенном сеансе команд, упрощенное описание которых дано ниже:

pwd(print working directory). Вывести имя текущего каталога.ls(list). Вывести содержимое каталога.echoВывести свой аргумент.cat(concatenate). Вывести содержимое файла.mkdir(make directory). Создать каталог.cp(copy). Скопировать файл.rm(remove). Удалить файл.

Многие команды имеют ряд аргументов, это, в частности, касается ls, которая выше была вызвана с аргументом -l. Аргументы разделяются пробелами и имеют префикс -.

Узнать об аргументах, которые принимает команда, можно с помощью аргумента --help:

localhost:~$ ls --help

BusyBox v1.31.1 () multi-call binary.

Usage: ls [-1AaCxdLHRFplinshrSXvctu] [-w WIDTH] [FILE]...

List directory contents

-1 One column output

-a Include entries which start with .

-A Like -a, but exclude . and ..

-x List by lines

-d List directory entries instead of contents

-L Follow symlinks

-H Follow symlinks on command line

-R Recurse

-p Append / to dir entries

-F Append indicator (one of */=@|) to entries

-l Long listing format

-i List inode numbers

-n List numeric UIDs and GIDs instead of names

-s List allocated blocks

-lc List ctime

-lu List atime

--full-time List full date and time

-h Human readable sizes (1K 243M 2G)

--group-directories-first

-S Sort by size

-X Sort by extension

-v Sort by version

-t Sort by mtime

-tc Sort by ctime

-tu Sort by atime

-r Reverse sort order

-w N Format N columns wide

--color[={always,never,auto}] Control coloring

Еще одним способом получить подробные сведения о конкретной команде является вызов вида man <команда>.

Без объяснений осталась строка echo 'new file' > new_file.txt в примере сеанса работы в командной строке выше. Здесь используется механизм перенаправления данных с помощью символов < (перенаправление ввода) и > (перенаправление вывода). В Linux имеется источник стандартного ввода stdin (код 0), а также два приемника стандартного вывода: stdout (код 1) и stderr (код 2, для ошибок). Организация ввода/вывода показана на рис. 3.

В примере ниже используется stdout и stderr:

localhost:~$ pwd

/root

localhost:~$ pwd > pwd.txt

localhost:~$ pwd --foo

sh: pwd: illegal option --

localhost:~$ pwd --foo 2> err.txt

localhost:~$ cat err.txt

sh: pwd: illegal option --

Обратите внимание на явное указание кода 2 при сохранении сообщения об ошибке в файл.

Перенаправление ввода/вывода превращается в очень мощную конструкцию при использовании такой организации команд, при которой вывод одной команды попадает на вход другой команды. Эта конструкция представляет собой конвейер и реализуется с помощью символа |, как показано в примере далее:

localhost:~$ pwd > pwd.txt

localhost:~$ rev --help

Usage: rev [options] [file ...]

Reverse lines characterwise.

Options:

-h, --help display this help

-V, --version display version

For more details see rev(1).

localhost:~$ rev pwd.txt

toor/

localhost:~$ pwd | rev

toor/

В Bash имеется удобный синтаксис для развертывания файловых путей (globbing). С помощью символов * (произвольная последовательность) и ? (произвольный символ) реализуется подстановка имен файлов в духе регулярных выражений, как в примере ниже:

localhost:~$ echo *

bench.py err.txt hello.c hello.js new_dir pwd.txt readme.txt rev

localhost:~$ echo *.c

hello.c

localhost:~$ echo p*

pwd.txt

localhost:~$ echo *.??

bench.py hello.js

В Bash есть возможность задать переменные и, кроме того, имеется ряд уже определенных переменных. Обратите внимание на особенности создания переменных:

localhost:~$ A = 42

sh: A: not found

localhost:~$ A=42

localhost:~$ A

sh: A: not found

localhost:~$ echo $A

42

С помощью команды set можно, помимо прочего, узнать, какие переменные сейчас заданы для текущего пользователя:

localhost:~$ set

A='42'

HISTFILE='/root/.ash_history'

HOME='/root'

HOSTNAME='localhost'

IFS='

'

LINENO=''

OLDPWD='/'

OPTIND='1'

PAGER='less'

PATH='/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin'

PPID='1'

PS1='\h:\w\$ '

PS2='> '

PS4='+ '

PWD='/root'

SHLVL='3'

TERM='linux'

TZ='UTC-03:00'

_='/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin'

script='/etc/profile.d/*.sh'

Особенно важна здесь переменная PATH, которая определяет те пути (разделенные с помощью :), где будет осуществляться поиск команд интерпретатором.

Linux является многопользовательской ОС и информация о зарегистрированных пользователях находится в конфигурационном файле /etc/passwd:

localhost:~$ whoami

root

localhost:~$ cat /etc/passwd

root:x:0:0:root:/root:/bin/ash

bin:x:1:1:bin:/bin:/sbin/nologin

daemon:x:2:2:daemon:/sbin:/sbin/nologin

adm:x:3:4:adm:/var/adm:/sbin/nologin

lp:x:4:7:lp:/var/spool/lpd:/sbin/nologin

sync:x:5:0:sync:/sbin:/bin/sync

shutdown:x:6:0:shutdown:/sbin:/sbin/shutdown

halt:x:7:0:halt:/sbin:/sbin/halt

mail:x:8:12:mail:/var/mail:/sbin/nologin

news:x:9:13:news:/usr/lib/news:/sbin/nologin

uucp:x:10:14:uucp:/var/spool/uucppublic:/sbin/nologin

operator:x:11:0:operator:/root:/sbin/nologin

man:x:13:15:man:/usr/man:/sbin/nologin

postmaster:x:14:12:postmaster:/var/mail:/sbin/nologin

cron:x:16:16:cron:/var/spool/cron:/sbin/nologin

ftp:x:21:21::/var/lib/ftp:/sbin/nologin

sshd:x:22:22:sshd:/dev/null:/sbin/nologin

at:x:25:25:at:/var/spool/cron/atjobs:/sbin/nologin

squid:x:31:31:Squid:/var/cache/squid:/sbin/nologin

xfs:x:33:33:X Font Server:/etc/X11/fs:/sbin/nologin

games:x:35:35:games:/usr/games:/sbin/nologin

cyrus:x:85:12::/usr/cyrus:/sbin/nologin

vpopmail:x:89:89::/var/vpopmail:/sbin/nologin

ntp:x:123:123:NTP:/var/empty:/sbin/nologin

smmsp:x:209:209:smmsp:/var/spool/mqueue:/sbin/nologin

guest:x:405:100:guest:/dev/null:/sbin/nologin

nobody:x:65534:65534:nobody:/:/sbin/nologin

dhcp:x:100:101:dhcp:/var/lib/dhcp:/sbin/nologin

svn:x:101:102:svn:/var/svn:/sbin/nologin

Информация о каждом из пользователей занимает отдельную строку. Строка разделяется символом : на поля. Первое поле означает имя пользователя. В нашем случае это root. Последнее поле указывает путь к интерпретатору оболочки ОС. В нашем случае это компактный Bash-подобный интерпретатор ash.

Вспомним, как выглядит вывод команды ls в long-формате:

localhost:~$ ls -l

total 20

-rw-r--r-- 1 root root 114 Jul 5 2020 bench.py

drwxr-xr-x 2 root root 37 Nov 4 18:01 foo

-rw-r--r-- 1 root root 76 Jul 3 2020 hello.c

-rw-r--r-- 1 root root 22 Jun 26 2020 hello.js

-rw-r--r-- 1 root root 151 Jul 5 2020 readme.txt

Первый столбец определяет права доступа и информацию о файле (-) или каталоге (d, как в случае с foo), закодированную в первом символе. Флаги доступа бывают следующих основных видов:

-Доступ запрещен.r(read). Имеется доступ на чтение.w(write). Имеется доступ на запись.x(execute). Имеется доступ на исполнение (на вход в случае каталога).

Рассмотрим детали на примере с файлом bench.py, который имеет следующие права доступа:

-rw-r--r-- 1 root root 114 Jul 5 2020 bench.py

|[-][-][-] [----] [----]

| | | | | |

| | | | | +-------------> 6. Группа

| | | | +---------------------> 5. Владелец

| | | |

| | | +----------------------------> 4. Права всех остальных

| | +-------------------------------> 3. Права группы

| +----------------------------------> 2. Права владельца

+------------------------------------> 1. Тип файла

При создании пользовательских команд необходимо указать права на исполнение, как показано в примере ниже:

localhost:~$ echo "ls -l" > lsl

localhost:~$ lsl

sh: lsl: not found

localhost:~$ ./lsl

sh: ./lsl: Permission denied

localhost:~$ chmod +x lsl

localhost:~$ ./lsl

total 24

-rw-r--r-- 1 root root 114 Jul 5 2020 bench.py

drwxr-xr-x 2 root root 37 Nov 4 18:01 foo

-rw-r--r-- 1 root root 76 Jul 3 2020 hello.c

-rw-r--r-- 1 root root 22 Jun 26 2020 hello.js

-rwxr-xr-x 1 root root 6 Nov 4 18:44 lsl

-rw-r--r-- 1 root root 151 Jul 5 2020 readme.txt

В Bash существует ряд специальных переменных, в частности:

$0. Путь к запущенной программе.$1, $2, .... Аргументы программы.$#. Количество аргументов программы.$@. Список аргументов программы.$?. Значение результата выполнения программы (0 означает успешное выполнение).

Рассмотрим в качестве примера следующую программу tests.sh:

echo $0

echo $1 $2

echo $#

echo $@

Результат ее выполнения показан далее:

localhost:~$ ./test.sh 1 2 3 4 5

./test.sh

1 2

5

1 2 3 4 5

localhost:~$ echo $?

0

localhost:~$ foo

sh: foo: not found

localhost:~$ echo $?

127

Рассмотрим теперь более сложный пример пользовательской команды. Далее приведен код на языке Bash вычисления факториала:

#!/bin/sh

seq "$1" | xargs echo | tr " " "*" | bc

В первой строке указан интерпретатор, который будет использоваться для исполнения программы. По соглашению, такую строку необходимо всегда указывать первой в пользовательских скриптах. Далее используется ряд новых команд.

Команда seq (sequence) генерирует последовательность чисел:

localhost:~$ seq 5

1

2

3

4

5

Команда xargs (extended arguments) форматирует список из стандартного ввода:

localhost:~$ seq 5 | xargs

1 2 3 4 5

Команда tr (translate) осуществляет замену текстовых фрагментов:

localhost:~$ seq 5 | xargs | tr " " "*"

1*2*3*4*5

Команда bc (basic calculator) представляет собой калькулятор:

localhost:~$ echo "2+2" | bc

4

Для вычислений в Bash можно также использовать скобки специального вида:

localhost:~$ echo $((2 + 2))

4

Для получения результата команды в виде аргумента другой команды можно также использовать скобки специального вида:

localhost:~$ echo "My folder is $(pwd)"

My folder is /root

В Bash имеются возможности полноценного языка программирования. Ниже приведен пример реализации факториала с использованием ветвлений и рекурсии:

#!/bin/sh

if [ "$1" -le 1 ] ; then

echo 1

return

fi

echo $(( $1 * $( ./fact.sh $(( $1 - 1 )) ) ))

Реализация факториала с использованием цикла:

#!/bin/sh

res=1

for i in $(seq 1 "$1"); do

res=$((res * i))

done

echo $res

Существует веб-инструмент ShellCheck [5], которым можно пользоваться для проверки корректности Bash-скриптов.

1.3. Инструменты командной строки

1.3. Инструменты командной строки

Команда grep (globally search for a regular expression and print matching lines) осуществляет поиск по образцу, определяемому регулярным выражением. Команда sed (stream editor) является строчным редактором, но главное ее использование состоит в замене по шаблону, как и в случае grep, заданному регулярным выражением.

В табл. 1 показаны примеры некоторых базовых элементов регулярного выражения.

| Символ | Действие |

|---|---|

| Буквы, числа, некоторые знаки | Обозначают сами себя |

. |

Любой символ |

[множество символов] |

Любой символ из множества |

[^множество символов] |

Любой символ не из множества |

^ |

Начало строки |

$ |

Конец строки |

^ |

Начало строки |

выражение* |

Повторение выражения 0 или более раз |

выражение выражение |

Последовательность из выражений |

Веб-инструмент regex101 [6] может помочь в поэлементном разборе сложных регулярных выражений.

С использованием grep и sed можно создать достаточно сложные схемы обработки данных. В частности, следующий код осуществляет проверку правописания для файла README.md на основе словаря из файла unix-words:

cat README.md | tr A-Z a-z | tr -cs A-Za-z '\n' | sort | uniq | grep -vx -f unix-words >out ; cat out | wc -l | sed 's/$/ mispelled words!/'

Еще более изощренной, чем grep и sed, является команда awk. AWK (по именам авторов – Aho, Weinberger, Kernighan) представляет собой язык программирования для обработки текстовых данных.

Ниже показан пример вывода колонки №5 из данных, предоставленных вызовом ls -l:

localhost:~$ ls -l

total 36

-rw-r--r-- 1 root root 114 Jul 5 2020 bench.py

-rwxr-xr-x 1 root root 51 Nov 4 18:56 fact.sh

-rwxr-xr-x 1 root root 76 Nov 4 19:45 fact2.sh

drwxr-xr-x 2 root root 37 Nov 4 18:01 foo

-rw-r--r-- 1 root root 76 Jul 3 2020 hello.c

-rw-r--r-- 1 root root 22 Jun 26 2020 hello.js

-rwxr-xr-x 1 root root 6 Nov 4 18:44 lsl

-rw-r--r-- 1 root root 151 Jul 5 2020 readme.txt

-rwxr-xr-x 1 root root 36 Nov 4 18:50 test.sh

localhost:~$ ls -l | awk '{ print $5 }'

114

51

76

37

76

22

6

151

36

Средствами awk легко подсчитать общий размер файлов:

localhost:~$ ls -l | awk '{ s += $5 } END { print s }'

569

В заключение рассмотрим пример вывода на экран самой свежей новости с ресурса Hacker News:

#!/bin/sh

N=$(curl -s https://hacker-news.firebaseio.com/v0/topstories.json | jq '.[0]')

curl -s "https://hacker-news.firebaseio.com/v0/item/$N.json" | jq '.["title"]' | cowsay

Вот как выглядит вывод этой программы:

localhost:~$ ./hn.sh

________________________________________

/ "Finishing my first game while working \

\ full-time" /

----------------------------------------

\ ^__^

\ (oo)\_______

(__)\ )\/\

||----w |

|| ||

На тему анализа данных в командной строке существует целая книга [7].

1.4. Модель конвейера

1.4. Модель конвейера

Для однонаправленной межпроцессной коммуникации на практике широко применяют перенаправление ввода/вывода и оператор конвейера |, при помощи которого результат работы одного процесса из его стандартного вывода (stdout) перенаправляется в стандартный ввод (stdin) другого процесса [8].

Рассмотрим ряд простых примеров использования конвейера. Например, при помощи утилиты head и оператора конвейера | легко получить первые 2 строки из файла /etc/passwd, содержащего список пользовательских учётных записей в Linux:

~$ cat /etc/passwd | head -n 2

root:x:0:0:root:/root:/bin/bash

daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin

Утилита cat направляет содержимое указанного файла в stdout. При помощи оператора конвейера | результат работы cat из stdout направляется в stdin утилиты head, которая, в свою очередь, направляет в stdout только первые 2 полученные строки, после чего завершает выполнение.

Для поиска по образцу можно воспользоваться утилитой grep:

~$ cat /etc/passwd | grep /usr | head -n 2

daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin

bin:x:2:2:bin:/bin:/usr/sbin/nologin

Теперь в вывод включены только те строки, которые содержат заданную подстроку /usr.

Оператор конвейера, помимо командной оболочки Linux, существует и в некоторых языках программирования общего назначения, таких как Elm [9] и F# [10]. Кроме того, в 2021 году рабочей группой TC39 ассоциации по стандартизации Ecma International было предложено добавить поддержку оператора конвейера в новую версию языка JavaScript, используемого для программирования веб-приложений [11].

Модель конвейера несложно реализовать и в Python, используя перегрузку оператора |.

1.4.1. Простая модель конвейера

Сначала попробуем воспроизвести рассмотренный пример работы с конвейером в командной оболочке Linux на Python при помощи цепочки вызовов простых функций, принимающих на вход список строк stdin и возвращающих новый список строк:

def cat(path):

# Получим список строк из файла, доступного по пути path.

with open(path, 'r', encoding='utf-8') as file:

return file.readlines()

def head(n, stdin):

# Воспользуемся срезом для получения n элементов из списка stdin.

return stdin[:n]

def grep(pat, stdin):

# Создадим новый список из строк, содержащих pat.

stdout = []

for line in stdin:

if pat in line:

stout.append(line)

return stdout

stdout = head(2, grep('/usr', cat('/etc/passwd')))

print(*stdout, sep='', end='')

Результатом работы функции cat является список строк. Полученный из файла /etc/passwd список строк подаётся на вход функции grep, которая возвращает только строки, содержащие подстроку /usr. Результат работы функции grep затем подаётся на вход функции head, возвращающей 2 первых элемента списка. Функция print выводит список строк в stdout.

Поместим наш код в файл pipe.py и попробуем запустить программу:

~$ python pipe.py

daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin

bin:x:2:2:bin:/bin:/usr/sbin/nologin

Для добавления поддержки оператора конвейера | в Python реализуем класс Pipe с перегрузкой оператора побитового «или», а также обновим наши функции так, чтобы они не выполняли вычисления в момент их вызова, а возвращали новые функции, которые будут вызваны при применении к экземпляру класса Pipe оператора конвейера | слева:

class Pipe:

def __init__(self, fun):

self.fun = fun

# Переопределим в классе метод __ror__, вызываемый при

# использовании оператора | слева от экземпляра класса Pipe.

def __ror__(self, lhs):

return self.fun(lhs)

def cat(path):

with open(path, 'r', encoding='utf-8') as file:

return file.readlines()

# Обновим реализацию функций head и grep.

def head(n):

def cmd(stdin):

return stdin[:n]

# В момент вызова функции head создадим экземпляр класса Pipe.

# Передадим в него ссылку на локальную функцию cmd.

return Pipe(cmd)

def grep(pat):

def cmd(stdin):

stdout = []

for line in stdin:

if pat in line:

stout.append(line)

return stdout

return Pipe(cmd)

stdout = cat('/etc/passwd') | grep('/usr') | head(2)

print(*stdout, sep='', end='')

Сравним результат работы модели конвейера с командной оболочкой Linux:

~$ cat /etc/passwd | grep /usr | head -n 2

daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin

bin:x:2:2:bin:/bin:/usr/sbin/nologin

~$ python pipe.py

daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin

bin:x:2:2:bin:/bin:/usr/sbin/nologin

Вывод программы совпадает с выводом утилит cat, grep и head, объединённых оператором конвейера в командной оболочке Linux. Расширим полученную модель конвейера, добавив поддержку сортировки с использованием стандартной функции sorted:

sort = Pipe(sorted)

stdout = cat('/etc/passwd') | grep('/usr') | head(3) | sort

print(*stdout, sep='', end='')

Убедимся, что полученная программа работает корректно:

~$ cat /etc/passwd | grep /usr | head -n 3 | sort

bin:x:2:2:bin:/bin:/usr/sbin/nologin

daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin

sys:x:3:3:sys:/dev:/usr/sbin/nologin

~$ python pipe.py

bin:x:2:2:bin:/bin:/usr/sbin/nologin

daemon:x:1:1:daemon:/usr/sbin:/usr/sbin/nologin

sys:x:3:3:sys:/dev:/usr/sbin/nologin

Полученная реализация оператора конвейера для Python, несмотря на простоту и заметное синтаксическое сходство с конвейером из командной оболочки Linux, не лишена недостатков, которые мы попробуем устранить в сопрограммной модели конвейера.

1.4.2. Сопрограммная модель конвейера

В предыдущей реализации модели все функции, которые могут использоваться вместе с конвейером |, должны быть реализованы по приведенному выше шаблону – эти функции обязательно возвращают новый экземпляр класса Pipe, в который передана ссылка на вложенную функцию, выполняющую вычисления.

Кроме того, в Linux выполнение объединенных при помощи конвейера процессов является сопрограммным – при получении данных из stdout первого процесса через stdin второй процесс сразу же начинает их обрабатывать, а в нашей реализации конвейера на Python списки строк обрабатываются функциями сразу целиком, функции выполняются не сопрограммно, а последовательно.

Первое замечание легко исправить, реализовав декоратор [12], позволяющий «превращать» обычные Python-функции в экземпляры класса Pipe, совместимые с оператором |. А для того, чтобы реализовать сопрограммную обработку строк, достаточно работу со списками заменить на работу с генераторами [13] – в этом случае каждая функция, являющаяся частью конвейера, не будет дожидаться обработки списка строк целиком, обработка элементов последовательности будет проводиться по мере получения новой строки от предыдущей функции.

Оставим без изменений определенный ранее класс Pipe с перегрузкой оператора |, добавим декоратор pipe и перепишем функции cat, head и grep, упростив их реализацию:

from itertools import islice

class Pipe:

def __init__(self, fun):

self.fun = fun

def __ror__(self, lhs):

return self.fun(lhs)

# Декоратор pipe, принимающий на вход функцию fun и

# возвращающий новую функцию, «оборачивающую» fun.

def pipe(fun):

def cmd(*args):

def read(stdin):

return fun(stdin, *args)

return Pipe(read)

return cmd

def cat(path):

with open(path, 'r', encoding='utf-8') as file:

for line in file:

yield line

@pipe

def head(stdin, n):

return islice(stdin, n)

@pipe

def grep(stdin, pat):

for line in stdin:

if pat in line:

yield line

sort = Pipe(sorted)

stdout = cat('/etc/passwd') | grep('/usr') | head(3) | sort

print(*stdout, sep='', end='')

Конструкция *args в списке параметров позволяет создать функцию, принимающую на вход произвольное число позиционных аргументов [12]. Функции cat, head и grep теперь возвращают не списки строк, а генераторы. Это достигается за счёт использования внутри каждой из этих функций оператора yield [13]. Реализация функции sort при этом осталась без изменений.

Добавим в нашу модель конвейера поддержку стандартной утилиты командной оболочки Linux tr и воспользуемся новой функцией, чтобы извлечь абсолютные пути из полученного ранее результата анализа файла /etc/passwd:

@pipe

def tr(stdin, old, new):

for line in stdin:

for pt in line.replace(old, new).splitlines(True):

yield pt

stdout = cat('/etc/passwd') | grep('/usr') | head(3) | tr(':', '\n') | grep('/') | sort

print(*stdout, sep='', end='')

Сравним вывод нашей Python-программы с результатами, полученными в командной оболочке Linux:

~$ cat /etc/passwd | grep /usr | head -n 3 | tr ':' '\n' | grep / | sort

/bin

/dev

/usr/sbin

/usr/sbin/nologin

/usr/sbin/nologin

/usr/sbin/nologin

~$ python pipe.py

/bin

/dev

/usr/sbin

/usr/sbin/nologin

/usr/sbin/nologin

/usr/sbin/nologin

1.4.3. Упражнения

Задача 1. Реализуйте поддержку команд uniq, wc, cut, curl.

Задача 2. Добавьте в модельный вариант grep поддержку регулярных выражений и опции -o. В частности, при помощи доработанной версии grep должно быть можно реализовать вывод имён пользователей, как в Linux: cat /etc/passwd | grep -E -o '^[A-Za-z_0-9-]+'

Задача 3. Реализуйте перенаправление ввода/вывода.

Задача 4. Реализуйте поддержку запуска внешних процессов в виде pipe-функций.

Задача 5. Создайте визуализатор конвейера с использованием инструмента Graphviz [14].

1.5. Конвейер на разных языках программирования

1.5. Конвейер на разных языках программирования

Поскольку при использовании конвейера коммуникация между разными процессами осуществляется через stdout и stdin, эти процессы могут быть представлены запущенными программами, написанными на разных языках программирования. Язык реализации при этом может быть как высокоуровневым, таким как, например, Python, так и низкоуровневым, таким как C.

Рассмотрим процесс разработки инструмента для поиска короткого фрагмента текста в больших текстовых файлах. Компоненты инструмента реализуем на разных языках программирования, а коммуникация между компонентами будет осуществляться сопрограммным образом, при помощи конвейера |.

Доступную в bash утилиту cat используем для получения в stdout содержимого заданного текстового файла. Содержимое файла будет передано по конвейеру утилите scan, разные версии которой мы реализуем на языках Python и С. Эта утилита будет выполнять поиск по короткой подстроке и возвращать результат в виде строки в формате JSON (JavaScript Object Notation) [15]. Утилита stats, в свою очередь, будет реализована на языке Python и использована для преобразования результата работы утилиты scan в понятное для человека табличное представление.

Организация ввода-вывода в нашем инструменте будет иметь вид, показанный на рис. 4:

Серым цветом на рис. 4 выделены утилиты, задействованные в конвейере.

Сначала воспользуемся утилитой командной строки Linux cat для получения в stdout строк из файла /var/log/syslog, содержащего сообщения о происходящих в системе событиях [3]. Также подсчитаем число строк в журнале событий:

~$ cat /var/log/syslog | tail -n 3

Jan 18 00:00:26 user-NBD-WXX9 systemd[1]: Started Make remote CUPS printers available locally.

Jan 18 00:00:26 user-NBD-WXX9 systemd[1]: dpkg-db-backup.service: Deactivated successfully.

Jan 18 00:00:26 user-NBD-WXX9 systemd[1]: Finished Daily dpkg database backup service.

~$ cat /var/log/syslog | wc -l

34031

Утилита tail используется для получения последних 3 строк из вывода cat.

1.5.1. Поиск по подстроке на языке Python

Теперь реализуем на Python утилиту scan.py для поиска по подстроке:

import sys

import json

pat = sys.argv[1]

for i, line in enumerate(sys.stdin):

if pat in line:

o = dict(line=i, content=line[:-1])

print(json.dumps(o))

Эта утилита построчно читает стандартный поток ввода stdin, а функция enumerate используется для получения номера прочитанной строки. В том случае, если переданный в качестве параметра командной строки короткий шаблон содержится в прочитанной строке, утилита scan отправляет в stdout строковое представление JSON-объекта, содержащего ключи line и content. Значением для ключа line является номер найденной строки в анализируемом файле. Значением для ключа content является содержимое строки, из которого удалён символ переноса строки на новую \n.

Для проверки работы scan.py попробуем найти подстроку root в файле /var/log/syslog:

~$ cat /var/log/syslog | python scan.py root | tail -n 3

{"line": 33903, "content": "Jan 17 22:30:01 user-NBD-WXX9 CRON[35710]: (root) CMD ([ -x /etc/init.d/anacron ] && if [ ! -d /run/systemd/system ]; then /usr/sbin/invoke-rc.d anacron start >/dev/null; fi)"}

{"line": 33955, "content": "Jan 17 23:17:01 user-NBD-WXX9 CRON[35863]: (root) CMD ( cd / && run-parts --report /etc/cron.hourly)"}

{"line": 33972, "content": "Jan 17 23:30:01 user-NBD-WXX9 CRON[35890]: (root) CMD ([ -x /etc/init.d/anacron ] && if [ ! -d /run/systemd/system ]; then /usr/sbin/invoke-rc.d anacron start >/dev/null; fi)"}

При помощи стандартной утилиты time [3] легко выполнить замеры времени выполнения реализованной утилиты по результатам 100 тестовых запусков поиска подстроки root в текстовом файле /var/log/syslog:

~$ time (for i in $(seq 1 100); do (cat /var/log/syslog | python scan.py root > /dev/null); done)

real 0m2,236s

user 0m1,897s

sys 0m0,583s

Команда seq 1 100 генерирует последовательность из 100 целых чисел. Оператор > позволяет перенаправить stdout в специальный файл /dev/null, который удаляет все записанные в него данные.

Попробуем ускорить поиск подстроки в текстовом файле, формируя JSON без создания временного словаря и без использования функции dumps из модуля json стандартной библиотеки языка Python. Обновим содержимое файла scan.py:

import sys

pat = sys.argv[1]

for i, line in enumerate(sys.stdin):

if pat in line:

print(f'{{"line": {i}, "content": "{line[:-1]}"}}')

Убедимся, что поведение утилиты не изменилось, и повторно измерим время её работы:

~$ cat /var/log/syslog | python scan.py root | tail -n 3

{"line": 33903, "content": "Jan 17 22:30:01 user-NBD-WXX9 CRON[35710]: (root) CMD ([ -x /etc/init.d/anacron ] && if [ ! -d /run/systemd/system ]; then /usr/sbin/invoke-rc.d anacron start >/dev/null; fi)"}

{"line": 33955, "content": "Jan 17 23:17:01 user-NBD-WXX9 CRON[35863]: (root) CMD ( cd / && run-parts --report /etc/cron.hourly)"}

{"line": 33972, "content": "Jan 17 23:30:01 user-NBD-WXX9 CRON[35890]: (root) CMD ([ -x /etc/init.d/anacron ] && if [ ! -d /run/systemd/system ]; then /usr/sbin/invoke-rc.d anacron start >/dev/null; fi)"}

~$ time (for i in $(seq 1 100); do (cat /var/log/syslog | python scan.py root > /dev/null); done)

real 0m1,668s

user 0m1,393s

sys 0m0,510s

Время выполнения утилиты scan.py снизилось, а результат выполнения не изменился.

1.5.2. Поиск по подстроке на языке C

Попробуем ускорить утилиту, реализовав на языке C сравнение строк как 64-битных целых чисел – в этом случае длина подстроки для поиска будет ограничена 8 символами, но процесс поиска должен ускориться. Создадим файл scan.c со следующим содержимым:

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <stdint.h>

#include <assert.h>

#define MAX_LINE 65536

int found(char *line, uint64_t pat, uint64_t mask) {

for (char *p = line; *p; p++) {

if ((*((uint64_t *) p) & mask) == pat) {

return 1;

}

}

return 0;

}

int main(int argc, char **argv) {

char line[MAX_LINE + sizeof(uint64_t)];

assert(argc == 2);

unsigned pat_size = strlen(argv[1]);

assert(pat_size <= sizeof(uint64_t));

uint64_t mask = (-1llu) >> (sizeof(uint64_t) - pat_size) * 8;

uint64_t pat = *((uint64_t *) argv[1]) & mask;

for (int i = 0; fgets(line, MAX_LINE, stdin) != NULL; i++) {

if (found(line, pat, mask)) {

line[strcspn(line, "\n")] = 0;

printf("{\"line\": %d, \"content\": \"%s\"}\n", i, line);

}

}

return 0;

}

В функции main сначала выделяется память для MAX_LINE + 8 символов и вычисляется размер шаблона для поиска – конструкция assert(pat_size <= 8) позволяет убедиться, что указанный пользователем шаблон занимает не более 8 байт, то есть включает в себя не более 8 ASCII-символов. После этого указатель на первый символ строкового шаблона, имеющий тип char*, преобразуется в указатель на беззнаковое целое, занимающее 8 байт – этот указатель имеет тип uint64_t*. На значение, полученное по указателю с типом uint64_t*, при помощи оператора побитового «и» & накладывается маска mask для того, чтобы установить равными 0 те биты, которые не относятся к указанному пользователем шаблону в том случае, если шаблон занимает меньше 8 байт.

Затем запускается цикл обработки строк, получаемых из stdin – чтение строк из стандартного ввода осуществляется при помощи стандартной функции fgets, определённой в заголовочном файле stdio.h. Функция found выполняет быстрый поиск шаблона pat в строке line по методу скользящего окна. Подстроки p, состоящие из 8 символов, сравниваются с шаблоном pat как 64-битные целые числа. В случае совпадения в stdout печатается JSON-строка, содержащая номер найденной строки и её содержимое, как и в версии утилиты, реализованной на языке Python.

Скомпилируем новую утилиту scan.c и проверим её работу:

~$ clang -O3 -o scan scan.c

~$ ls

scan scan.c scan.py

~$ cat /var/log/syslog | ./scan root | tail -n 3

{"line": 33903, "content": "Jan 17 22:30:01 user-NBD-WXX9 CRON[35710]: (root) CMD ([ -x /etc/init.d/anacron ] && if [ ! -d /run/systemd/system ]; then /usr/sbin/invoke-rc.d anacron start >/dev/null; fi)"}

{"line": 33955, "content": "Jan 17 23:17:01 user-NBD-WXX9 CRON[35863]: (root) CMD ( cd / && run-parts --report /etc/cron.hourly)"}

{"line": 33972, "content": "Jan 17 23:30:01 user-NBD-WXX9 CRON[35890]: (root) CMD ([ -x /etc/init.d/anacron ] && if [ ! -d /run/systemd/system ]; then /usr/sbin/invoke-rc.d anacron start >/dev/null; fi)"}

$ time (for i in $(seq 1 100); do (cat /var/log/syslog | ./scan root > /dev/null); done)

real 0m0,543s

user 0m0,452s

sys 0m0,321s

Время выполнения утилиты scan.c, реализованной на языке C, в 4 раза ниже, чем время выполнения первой реализации scan.py на языке Python, и в 3 раза ниже, чем время выполнения ускоренной реализации scan.py на языке Python.

1.5.3. Вывод статистики на языке Python

Полученную последовательность найденных строк в формате JSON легко преобразовать в понятное человеку представление при помощи стороннего модуля для Python tabulate, перед использованием модуль tabulate необходимо установить из реестра пакетов PyPI (Python Package Index) [16].

Реализуем утилиту stats.py следующим образом:

import sys

import json

from tabulate import tabulate

print(tabulate([json.loads(line).values() for line in sys.stdin],

headers=['Строка', 'Содержимое'],

maxcolwidths=[None, 50]))

Утилита stats.py читает все строки в формате JSON из stdin, извлекает из JSON-объектов значения, и передаёт на вход функции tabulate сформированный список, содержащий вложенные списки значений. После этого сформированная модулем tabulate [16] таблица выводится в stdout:

~$ cat /var/log/syslog | ./scan root | tail -n 3 | python stats.py

Строка Содержимое

-------- -------------------------------------------------

33903 Jan 17 22:30:01 user-NBD-WXX9 CRON[35710]: (root)

CMD ([ -x /etc/init.d/anacron ] && if [ ! -d

/run/systemd/system ]; then /usr/sbin/invoke-rc.d

anacron start >/dev/null; fi)

33955 Jan 17 23:17:01 user-NBD-WXX9 CRON[35863]: (root)

CMD ( cd / && run-parts --report

/etc/cron.hourly)

33972 Jan 17 23:30:01 user-NBD-WXX9 CRON[35890]: (root)

CMD ([ -x /etc/init.d/anacron ] && if [ ! -d

/run/systemd/system ]; then /usr/sbin/invoke-rc.d

anacron start >/dev/null; fi)

1.5.4. Упражнения

Задача 1. Что будет, если в обрабатываемой с помощью scan строке появится символ двойной кавычки? Исправьте соответствующим образом код.

Задача 2. Замените в конвейере формат JSON на CSV (Comma-Separated Values). Заголовки колонок должны передаваться программе как параметры командной строки.

Задача 3. Сравните производительность scan с вариантом реализации, использующим стандартную функцию strstr.

Задача 4. Почему grep оказывается быстрее scan? Улучшите код scan с использованием POSIX-функции read, чтобы приблизиться к показателям grep.

Задача 5. Реализуйте scan на языке, отличном от Python и C. Составьте таблицу с оценками производительности всех полученных вариантов scan.

1.6. Однострочники для анализа данных

1.6. Однострочники для анализа данных

1.6.1. Разбор JSON для получения статистики из GitHub

Рассмотрим задачу получения сведений о git-репозиториях пользователя GitHub посредством взаимодействия по протоколу HTTP (Hypertext Transfer Protocol) с удалённым API (Application Programming Interface), возвращающим данные в формате JSON [15]. Отправка запросов и разбор ответов сервера будет осуществляться при помощи утилит командной оболочки Linux. Полученные сведения о репозиториях будут включать их имена и число «звёзд», равное количеству пользователей, добавивших репозиторий в список «избранное».

Начнём с получения списка репозиториев пользователя в формате JSON. В GitHub HTTP API настроены лимиты на число запросов в час, поэтому при помощи утилиты curl отправим единственный HTTP-запрос к API и, воспользовавшись оператором перенаправления вывода >, сохраним результат в файл repos.json. Получим список репозиториев, владельцем которых является пользователь GitHub с именем true-grue:

~$ curl -s https://api.github.com/users/true-grue/repos > repos.json

~$ cat repos.json | head -n 5

[

{

"id": 207806577,

"node_id": "MDEwOlJlcG9zaXRvcnkyMDc4MDY1Nzc=",

"name": "algomusic",

Опция -s используется для отключения вывода диагностических сообщений утилиты curl. Файл repos.json теперь содержит массив объектов со сведениями о репозиториях пользователя GitHub true-grue. В вывод, ограниченный первыми 5 строками, включён идентификатор и имя репозитория algomusic.

Для обработки полученного массива объектов со сведениями о репозиториях воспользуемся утилитой jq [17], предназначенной для преобразования строк в формате JSON и для извлечения данных из них. Утилиту jq версии не ниже 1.6 потребуется установить дополнительно при помощи Вашего пакетного менеджера. Начнём с извлечения объектов из массива, содержащегося в файле repos.json:

~$ cat repos.json | jq '.[0]' | head -n 5

{

"id": 207806577,

"node_id": "MDEwOlJlcG9zaXRvcnkyMDc4MDY1Nzc=",

"name": "algomusic",

"full_name": "true-grue/algomusic",

~$ cat repos.json | jq '.[1]' | head -n 5

{

"id": 427108160,

"node_id": "R_kgDOGXUnQA",

"name": "awesome-russian-cs-books",

"full_name": "true-grue/awesome-russian-cs-books",

Выражение .[i] в списке параметров jq используется для получения \(i\)-го элемента из массива JSON-объектов: выражение .[0] позволяет получить первый элемент массива, а выражение .[1] – второй элемент.

Теперь извлечём имена репозиториев из JSON-объектов по ключу name:

~$ cat repos.json | jq '.[0].name'

"algomusic"

~$ cat repos.json | jq '.[1].name'

"awesome-russian-cs-books"

Для извлечения нескольких значений по нескольким ключам можно воспользоваться оператором конвейера | внутри строки запроса jq. В этом случае каждое полученное значение будет размещено на новой строке:

~$ cat repos.json | jq '.[0] | (.name, .stargazers_count)'

"algomusic"

11

~$ cat repos.json | jq '.[1] | (.name, .stargazers_count)'

"awesome-russian-cs-books"

38

Значения из JSON, имеющие строковой тип данных, выведены в stdout с обрамляющими двойными кавычками, а числовые значения выведены без кавычек. В случае, если необходимо соединить значения полей, можно воспользоваться оператором конкатенации строк +, но числа при этом необходимо явно преобразовать в строки при помощи оператора tostring. Кроме того, подобное преобразование легко применить сразу ко всем JSON-объектам в массиве, заменив .[0] на .[]:

~$ cat repos.json | jq '.[] | (.name + " " + (.stargazers_count | tostring))' | head -n 5

"algomusic 11"

"awesome-russian-cs-books 38"

"ayumi 88"

"BytePusher 6"

"code-snippets 3"

Отсортируем полученный перечень репозиториев по их числу «звёзд», равному количеству добавлений репозиториев в список «избранное» пользователями GitHub. Для этого воспользуемся стандартной утилитой sort, предварительно заменив двойные кавычки на пустые строки утилитой sed:

~$ cat repos.json | jq '.[] | (.name + " " + (.stargazers_count | tostring))' | sed 's/"//g' | sort -k 2 -n -r | head -n 5

Compiler-Development 498

kispython 203

ayumi 88

kisscm 84

raddsl 83

Команда s утилиты sed имеет синтаксис s/шаблон/замена/опции, а опция g переключает утилиту sed в режим глобального поиска и замены. С опцией g вместо однократной замены все двойные кавычки заменятся на пустые строки. Опция -k утилиты sort позволяет указать номер колонки, по которому необходимо упорядочить строки, при этом в качестве разделителя колонок используется пробел. Опция -n включает численную сортировку, а опция -r меняет порядок сортировки на обратный.

Преобразуем результат в формат csv, заменив пробел на запятую при помощи утилиты tr, и выведем в stdout таблицу с данными:

~$ cat repos.json | jq '.[] | (.name + " " + (.stargazers_count | tostring))' | sed 's/"//g' | sort -k 2 -n -r | tr ' ' ',' | csvlook -H | head -n 7

| a | b |

| -------------------- | --- |

| Compiler-Development | 498 |

| kispython | 203 |

| ayumi | 88 |

| kisscm | 84 |

| raddsl | 83 |

Для вывода на экран оформленной таблицы мы воспользовались утилитой csvlook из пакета утилит csvkit [18]. Пакет утилит csvkit версии не ниже 2.0.1 потребуется установить дополнительно при системного пакетного менеджера или пакетного менеджера PyPI. Опция -H утилиты csvlook позволяет использовать имена колонок по умолчанию, поскольку наш вывод в формате csv не содержит строки-заголовка. В качестве имён колонок в csvlook с опцией -H используются буквы английского алфавита.

Добавим строку-заголовок к выводу в формате csv при помощи AWK [19]:

~$ cat repos.json | jq '.[] | (.name + " " + (.stargazers_count | tostring))' | sed 's/"//g' | sort -k 2 -n -r | tr ' ' ',' | awk 'BEGIN { print "Репозиторий,Звёзд" } { print }' | csvlook | head -n 7

| Репозиторий | Звёзд |

| -------------------- | ----- |

| Compiler-Development | 498 |

| kispython | 203 |

| ayumi | 88 |

| kisscm | 84 |

| raddsl | 83 |

В языке AWK инструкция в фигурных скобках, указанная после ключевого слова BEGIN, выполняется однократно в момент начала выполнения команды, и в результате в вывод попадает строка Репозиторий,Звёзд. Инструкция print, указанная следующей также в фигурных скобках, выполняется для каждой строки, поступившей на вход утилите awk через stdin.

Полученный набор команд, объединённых оператором конвейера |, можно упростить, возвращая несколько строк после разбора JSON утилитой jq и объединяя полученные пары строк в одну утилитой xargs со значением параметра -n, равным 2. В случае, если утилита jq вызывается с опцией необработанного вывода -r, нет необходимости в преобразовании типов данных функцией tostring и в удалении двойных кавычек – в stdout значения полей name и stargazers_count попадут как строки, не обрамлённые кавычками. Кроме того, заменять символ пробела на запятую при формировании csv можно прямо в программе на языке AWK, без задействования утилиты tr. Объединим все инструкции в один конвейер:

~$ curl -s https://api.github.com/users/true-grue/repos \

> | jq -r '.[] | (.name, .stargazers_count)' \

> | xargs -n 2 \

> | sort -nrk2 \

> | awk 'BEGIN { print "Репозиторий,Звёзд" } { print $1 "," $2 }' \

> | csvlook \

> | head -n 7

| Репозиторий | Звёзд |

| -------------------- | ----- |

| Compiler-Development | 498 |

| kispython | 203 |

| ayumi | 88 |

| kisscm | 84 |

| raddsl | 83 |

В приведённом примере кода символ \ используется для игнорирования служебного символа переноса строки \n. Это позволяет разбивать на несколько строк длинные команды, в которых разные утилиты объединяются в одну команду при помощи оператора конвейера |.

При помощи реализованного конвейера легко получить статистику по репозиториям другого пользователя, заменив имя пользователя true-grue в ссылке, являющейся параметром утилиты curl. Попробуем в таком же формате вывести сведения о репозиториях, к которым имеет доступ пользователь GitHub worldbeater – такой фильтр можно включить, установив параметр строки запроса type равным значению member. Переносить фрагменты команды на новую строку можно и без использования символа \, как в предыдущем примере – достаточно закончить строку оператором конвейера |:

~$ curl -s https://api.github.com/users/worldbeater/repos?type=member |

jq -r '.[] | (.name, .stargazers_count)' |

xargs -n 2 |

sort -nrk2 |

awk 'BEGIN { print "Репозиторий,Звёзд" } { print $1 "," $2 }' |

csvlook |

head -n 7

| Репозиторий | Звёзд |

| --------------------- | ----- |

| Camelotia | 567 |

| Citrus.Avalonia | 565 |

| Live.Avalonia | 409 |

| ReactiveUI.Validation | 245 |

| ReactiveMvvm | 180 |

Реализованный конвейер показан на рис. 5:

Белом цветом на рис. 5 выделены стандартные утилиты командной оболочки Linux, серым цветом выделены утилиты jq [17] и csvlook [18], которые были установлены отдельно при помощи пакетного менеджера.

1.6.2. Разбор XLSX для поиска бассейнов

В этом разделе рассмотрим задачу обработки табличных данных в формате XLSX (Excel Spreadsheet), полученных из Портала открытых данных Правительства Москвы [20] и содержащих сведения о крытых плавательных бассейнах города, для поиска бассейнов длиной более 25 метров. Начнем с экспорта данных в формате XLSX со страницы [20]. Загрузить данные со страницы [20] можно, нажав на кнопку «экспорт» и выбрав предпочтительный формат или воспользовавшись утилитой curl, указав через опцию -o имя файла, в который необходимо сохранить загруженный ZIP-архив с таблицей:

~$ curl -s -o data.zip https://data.mos.ru/odata/export/catalog?idFile=263870

~$ unzip data.zip

Archive: data.zip

inflating: data-890-2025-01-17.xlsx

~$ ls

data-890-2025-01-17.xlsx data.zip

Для разбора XLSX-файла воспользуемся утилитой in2csv из пакета утилит csvkit [18]. Преобразуем XLSX-файл, извлечённый из ZIP-архива data.zip, в формат CSV. Опция --reset-dimensions утилиты in2csv позволяет обеспечить поддержку XLSX-таблиц, созданных в приложениях, не сохраняющих в файл с таблицей такие метаданные, как фактическое число строк и столбцов в таблице. Ограничим результат преобразования, выведенный в stdout, первыми 3 строками при помощи утилиты head:

~$ in2csv --reset-dimensions data-890-2025-01-17.xlsx | head -n 3

<frozen importlib._bootstrap>:914: ImportWarning: _SixMetaPathImporter.find_spec() not found; falling back to find_module()

...

При работе утилиты in2csv в стандартный вывод ошибок (stderr) [8] был напечатан ряд диагностических сообщений. Содержимое stderr можно перенаправить в специальный файл /dev/null для игнорирования диагностических сообщений при помощи перенаправления вывода > с указанием дескриптора 2, связанного с stderr:

~$ in2csv --reset-dimensions data-890-2025-01-17.xlsx 2>/dev/null | head -n 3

global_id,ObjectName,NameSummer,PhotoSummer,AdmArea,District,Address,Email,WebSite,HelpPhone,HelpPhoneExtension,WorkingHoursSummer,ClarificationOfWorkingHoursSummer,HasEquipmentRental,EquipmentRentalComments,HasTechService,TechServiceComments,HasDressingRoom,HasEatery,HasToilet,HasWifi,HasCashMachine,HasFirstAidPost,HasMusic,UsagePeriodSummer,DimensionsSummer,Lighting,...

global_id,Название спортивного объекта,Название спортивной зоны ...

2721621929,Бассейн плавательный Московской академии фигурного ...

Из содержимого stdout следует, что первые 2 строки в XLSX-файле содержат заголовки столбцов таблицы на английском и русском языках. При этом названия бассейнов приводятся во 2-м столбце с именем ObjectName, а сведения о размерах бассейнов – в 26-м столбце с именем DimensionsSummer. Передав опцию --skip-lines можно указать утилите in2csv, что при преобразовании XLSX-таблицы в CSV необходимо пропустить первые 2 строки с заголовками столбцов:

~$ in2csv --skip-lines 2 --reset-dimensions data-890-2025-01-17.xlsx 2>/dev/null |

head -n 3

2721621929,Бассейн плавательный Московской академии фигурного катания на коньках,"Бассейн плавательный крытый, нестандартного размера","Photo:b96a1334-8eff-4030-9aaa-5754599e9ea3

",Северо-Восточный административный округ,район Южное Медведково,"Заповедная улица, дом 1",mmpa@mossport.ru,mmpa.mossport.ru,(499) 790-30-77,k,"DayOfWeek:понедельник

Теперь воспользуемся утилитой csvcut из пакета csvkit [18], чтобы исключить из полученной таблицы в формате CSV все строки, кроме 2-й, содержащей названия бассейнов, и 26-й, содержащей сведения о размерах бассейнов:

~$ in2csv --skip-lines 2 --reset-dimensions data-890-2025-01-17.xlsx 2>/dev/null |

csvcut -c 2,26 | head -n 7

Бассейн плавательный Московской академии фигурного катания на коньках,"Square:132.8

Length:16.6

Width:8

Depth:

"

"Спортивный комплекс «Косино», д.8А","Square:400

Опция -c утилиты csvcut позволяет указать через запятую номера тех столбцов, которые необходимо оставить в stdout. Полученный вывод теперь состоит всего из 2 столбцов, но при этом содержимое ячеек и 1-го столбца, и 2-го столбца может включать в себя как символ переноса строки на новую \n, так и запятую. Эти символы используются в формате CSV по умолчанию: символ \n разделяет строки, а запятая разделяет столбцы. В случае, если ячейка таблицы содержит разделитель, значение ячейки обрамляется двойными кавычками, как показано в выводе утилиты in2csv выше. Длина бассейна указана напротив строки Length: во втором столбце.

При помощи утилиты csvformat заменим разделители строк и столбцов CSV с символов переноса строки и запятой на символ @ и точку с запятой соответственно. Убедимся, что в выводе теперь отсутствуют двойные кавычки:

~$ in2csv --skip-lines 2 --reset-dimensions data-890-2025-01-17.xlsx 2>/dev/null |

csvcut -c 2,26 | csvformat -M '@' -D ';' | head -n 7

Бассейн плавательный Московской академии фигурного катания на коньках;Square:132.8

Length:16.6

Width:8

Depth:

@Спортивный комплекс «Косино», д.8А;Square:400

Length:25

При помощи утилиты tr заменим @ на символ переноса строки на новую \n, а символ \n заменим на пробел. Теперь в выводе команды все сведения о бассейне расположены на одной строке – это позволит в дальнейшем воспользоваться инструментами построчной обработки данных:

~$ in2csv --skip-lines 2 --reset-dimensions data-890-2025-01-17.xlsx 2>/dev/null |

csvcut -c 2,26 | csvformat -M '@' -D ';' | tr '@\n' '\n ' | head -n 3

Бассейн плавательный Московской академии фигурного катания на коньках;Square:132.8 Length:16.6 Width:8 Depth:

Спортивный комплекс «Косино», д.8А;Square:400 Length:25 Width:16 Depth:2.2

Бассейн плавательный «ЦСиО Самбо-70 отделение Юность»;Square:128 Length:16 Width:8 Depth:

При помощи утилиты sed в расширенном режиме с поддержкой регулярных выражений извлечём из каждой строки название бассейна и длину бассейна. Расширенный режим sed включается опцией -E:

~$ in2csv --skip-lines 2 --reset-dimensions data-890-2025-01-17.xlsx 2>/dev/null |

csvcut -c 2,26 | csvformat -M '@' -D ';' | tr '@\n' '\n ' |

sed -E 's/(.+);.*Length:([0-9.]+).*/\1;\2/' | head -n 3

Бассейн плавательный Московской академии фигурного катания на коньках;16.6

Спортивный комплекс «Косино», д.8А;25

Бассейн плавательный «ЦСиО Самбо-70 отделение Юность»;16

Указанный в аргументах команды sed после s/ фрагмент регулярного выражения [21] (.+); распознаёт от 1 до \(\infty\) любых символов, стоящих перед точкой с запятой, и добавляет распознанные символы в первую группу за счёт использования круглых скобок впервые в регулярном выражении, после чего пропускается символ ;. Затем правило .*Length: пропускает от 0 до \(\infty\) любых символов, предшествующих строке Length:, также пропускается сама строка Length:. После этого правилом ([0-9.]+) распознаётся и добавляется во вторую группу последовательность, содержащая от 1 до \(\infty\) символов цифр или символа точки, за счёт повторного использования круглых скобок в регулярном выражении. Наконец, пропускается от 0 до \(\infty\) любых оставшихся символов – этому правилу соответствует шаблон .*.

Ссылка на первую группу в секции замены sed указывается как \1, а ссылка на вторую группу – как \2. Таким образом, выражение \1;\2 указывает, что результатом замены, выполняемой утилитой sed, должно стать название бассейна, разделитель в виде символа точки с запятой, и длина бассейна.

При помощи программы на языке AWK добавим к таблице заголовок и оставим в выводе только те бассейны, длина которых превышает 25 метров. Преобразуем таблицу в понятное человеку представление при помощи утилиты csvlook [18]:

~$ in2csv --skip-lines 2 --reset-dimensions data-890-2025-01-17.xlsx 2>/dev/null |

csvcut -c 2,26 | csvformat -M '@' -D ';' | tr '@\n' '\n ' |

sed -E 's/(.+);.*Length:([0-9.]+).*/\1;\2/' |

awk -F ';' 'BEGIN {print "Бассейн;Длина"} $2 > 25 {print}' |

csvlook --max-column-width 50

| Бассейн | Длина |

| -------------------------------------------------- | ----- |

| Спортивный комплекс «Косино», д.8Б | 50,0 |

| Спортивный комплекс «Луч» (плавательный бассейн) | 25,7 |

| Многофункциональный спортивный комплекс «Формул... | 50,0 |

| Спортивный комплекс высшего учебного заведения | 29,3 |

| Физкультурно-оздоровительный комплекс с бассейн... | 50,0 |

| Дворец спорта «Москвич» | 50,0 |

| Спортивный комплекс «Баланс» | 39,0 |

| Спортивный комплекс «Акватория ЗИЛ» | 50,0 |

| Центр современного пятиборья «Северный» | 50,0 |

В awk после однократного выполнения инструкции, указанной в фигурных скобках сразу за ключевым словом BEGIN, для каждой строки вычисляется выражение $2 > 25, где $2 обозначает номер колонки. В качестве разделителя колонок используется аргумент опции -F утилиты awk – точка с запятой. В случае, если выражение $2 > 25 истинно, выполняется следующая сразу за ним инструкция в фигурных скобках – в stdout печатается строка CSV-таблицы.

Реализованный конвейер показан на рис. 6:

Белом цветом на рис. 6 выделены стандартные утилиты командной оболочки Linux, серым цветом выделены утилиты in2csv, csvcut, csvformat и csvlook из пакета утилит csvkit [18], который устанавливается отдельно.

1.6.3. Разбор HTML для получения индекса Хирша

Рассмотрим процесс решения практической задачи в командной строке Linux по получению и обработке данных публикационной активности исследователя с целью вычисления его индекса Хирша. Данные для вычисления будем получать из Российской научной электронной библиотеки Elibrary по протоколу HTTP.

Индекс Хирша – это наукометрический показатель, предложенный Jorge E. Hirsch в работе [22] и широко используемый для численной оценки продуктивности учёных или научных групп [23]. Согласно [22], учёный имеет индекс \(h\), если им опубликовано как минимум \(h\) статей, каждая из которых имеет как минимум \(h\) цитирований.

Библиотека Elibrary интегрирована с Российским индексом научного цитирования (РИНЦ) и позволяет получить список публикаций автора через веб-интерфейс, показанный на рис. 7, по уникальному идентификатору автора [24]:

Попробуем получить список публикаций автора с идентификатором 260020 при помощи утилиты curl:

~$ curl -s https://elibrary.ru/author_items.asp?authorid=260020

<head><title>Object moved</title></head>

<body>

<h1>Object Moved</h1>

This object may be found <a href="https://www.elibrary.ru/author_items.asp?authorid=260020">here</a>.

</body>

Утилита curl с опцией -s отправляет GET-запрос на заданный адрес, а опция -s указывает, что не нужно выводить диагностическую информацию. Судя по полученному ответу, веб-сервер Elibrary перенаправляет нас на новый адрес запрашиваемого HTTP-ресурса. Включим обработку HTTP-заголовка location опцией -L для автоматических перенаправлений и снова попытаемся получить список публикаций автора с идентификатором 260020:

~$ curl -s -L https://elibrary.ru/author_items.asp?authorid=260020

<!DOCTYPE html>

<html>

<link rel="stylesheet" href="/style_sm.css" type="text/css" media="screen">

<body>

<div class="midtext">

<img src="/images/error.png" border=0 width=100 height=100 vspace=8><br>

Ошибка в параметрах страницы, <br>или недостаточно прав для открытия страницы.<br>

Уточните запрос или <br>перейдите на <a href="/defaultx.asp">главную страницу сайта</a>

</div>

</body>

</html>

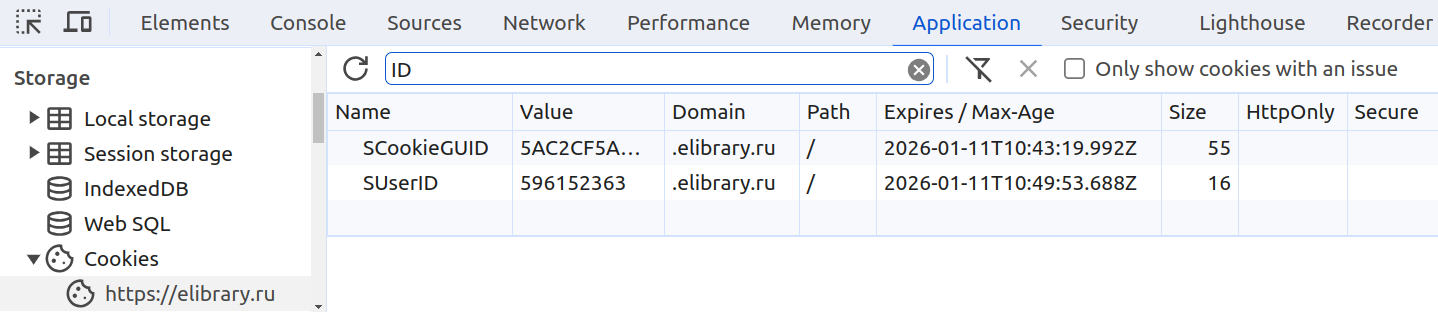

Для загрузки списка публикаций нам необходимо авторизоваться и получить идентификатор сессии Elibrary. Для этого достаточно открыть в веб-браузере ссылку [24], войти на сайт Elibrary, включить инструменты разработчика и извлечь значения SUserID и SCookieGUID из HTTP Cookie для сайта https://www.elibrary.ru. Эти значения будут использоваться в дальнейшем при отправке запросов к Elibrary.

Рассмотрим процесс извлечения идентификатора сессии на примере браузера Google Chrome:

- Выполним вход на сайт Elibrary или зарегистрируем новый аккаунт.

- Откроем страницу со списком публикаций автора 260020 на Elibrary [24].

- Включим инструменты разработчика, нажав клавишу F12.

- В панели инструментов разработчика перейдем на вкладку Application.

- В разделе Storage развернём секцию Cookies и выберем

https://www.elibrary.ru. - Сохраним значения

SUserIDиSCookieGUID(см. рис. 8) для дальнейшего использования.

Вновь попробуем получить список публикаций автора, отправив GET-запрос при помощи curl на адрес [24], но уже с опциями --cookie, значения для которых были получены на предыдущем шаге:

~$ curl -s -L -o author.html --cookie "SCookieGUID=%guid%" --cookie "SUserID=%user%" https://elibrary.ru/author_items.asp?authorid=260020

~$ cat author.html | head -n 5

<!DOCTYPE html>

<html>

<head>

<meta name="robots" content="noindex,nofollow">

Вместо %guid% и %user% необходимо подставить значения HTTP Cookie SCookieGUID и SUserID, полученные из браузера при помощи инструментов разработчика. Опция -o author.html используется, чтобы сохранить ответ сервера в файл author.html вместо вывода в stdout.

В файле author.html теперь находится разметка страницы в формате HTML (Hypertext Markup Language) со сведениями о первых 100 публикациях автора с идентификатором 260020 на Elibrary [24]. Для каждой публикации сохранено её название, сведения об авторах, а также число цитирований. Для вычисления индекса Хирша необходимо разобрать HTML-разметку, сохранённую в файле author.html, и для каждой из публикаций извлечь число её цитирований.

При работе с языками программирования общего назначения для разбора HTML широко используются специализированные инструменты, выполняющие построение объектной модели документа (Document Object Model, DOM), после чего выполняется обход DOM для извлечения необходимых данных. Например, для разбора HTML в Python можно воспользоваться библиотекой BeautifulSoup [25].

Однако, в этом разделе мы намеренно ограничимся только утилитами, доступными в командной оболочке Linux. Сначала убедимся, что в файле author.html действительно 100 статей. Анализируя содержимое файла author.html легко заметить, что сведения о каждой из статей приведены внутри HTML-тега tr с атрибутами valign и id, причём значение атрибута id содержит идентификатор, который может включать в себя как буквы, так и цифры. Воспользуемся утилитами grep и wc для подсчёта строк, содержащих HTML-тег tr с описанными выше атрибутами:

~$ cat author.html | grep -E '<tr valign=middle id="[a-z0-9]+"' | wc -l

100

Опция -E переводит утилиту grep в расширенный режим с поддержкой регулярных выражений, а опция -l указывает, что утилита wc должна подсчитать количество строк.

Теперь, аналогичным образом анализируя HTML-разметку, получим HTML-тег с числом цитирований для каждой из статей, на которую есть хотя бы одна ссылка. Ограничим вывод сведениями о первых 5 статьях:

~$ cat author.html | grep -E 'title="Список статей, ссылающихся на данную">[0-9]+' | head -n 5

<a href="cit_items.asp?gritemid=44028520" title="Список статей, ссылающихся на данную">2</a>

<a href="cit_items.asp?gritemid=37080577" title="Список статей, ссылающихся на данную">50</a>

<a href="cit_items.asp?gritemid=29992112" title="Список статей, ссылающихся на данную">5</a>

<a href="cit_items.asp?gritemid=45625467" title="Список статей, ссылающихся на данную">1</a>

<a href="cit_items.asp?gritemid=61567780" title="Список статей, ссылающихся на данную">1</a>

Добавим к grep в расширенном режиме опцию -o, указывающую, что для каждой строки из stdin, включающей в себя подстроку, соответствующую регулярному выражению title="Список статей, ссылающихся на данную">[0-9]+, необходимо выбрать и вывести в stdout только тот фрагмент, который полностью соответствует регулярному выражению:

~$ cat author.html | grep -E -o 'title="Список статей, ссылающихся на данную">[0-9]+' | head -n 5

title="Список статей, ссылающихся на данную">2

title="Список статей, ссылающихся на данную">50

title="Список статей, ссылающихся на данную">5

title="Список статей, ссылающихся на данную">1

title="Список статей, ссылающихся на данную">1

Упростим регулярное выражение в grep, после чего повторно применим grep для того, чтобы оставить в выводе только число цитирований статей. Затем отсортируем число цитирований по убыванию:

~$ cat author.html | grep -E -o 'данную">[0-9]+' | grep -E -o '[0-9]+' | sort -n -r | head -n 5

50

50

16

14

13

Теперь перейдём к подсчёту индекса Хирша. Поскольку у нас есть отсортированные количества цитирований статей, для подсчёта индекса Хирша воспользуемся следующим алгоритмом: если номер текущей строки меньше или равен значению, расположенному на этой строке, то увеличиваем индекс Хирша на 1.

Этот алгоритм легко реализовать на языке AWK [19]:

~$ cat author.html | grep -Eo 'данную">[0-9]+' | grep -Eo '[0-9]+' | sort -nr | awk 'NR <= $1 { c += 1 } END { print c }'

7

Переменная NR увеличивается в AWK на 1 для каждой прочитанной из stdin строки, а переменная $1 содержит прочитанное значение. Блок { c += 1 } выполняется только в том случае, если условие перед ним истинно. Блок END { print c } выполняется после обработки всех строк из stdin и выводит на экран значение переменной c – вычисленный индекс Хирша.

Полная версия программы на Bash для вычисления индекса Хирша по 100 публикациям на Elibrary имеет вид:

~$ curl -s -L --cookie "SCookieGUID=%guid%" --cookie "SUserID=%user%" \

> https://elibrary.ru/author_items.asp?authorid=260020 \

> | grep -Eo 'данную">[0-9]+' \

> | grep -Eo '[0-9]+' \

> | sort -nr \

> | awk 'NR <= $1 { c += 1 } END { print c }'

7

Реализованный конвейер показан на рис. 9:

Легко вычислить индекс Хирша по 100 публикациям и для другого автора, заменив authorid.

~$ curl -s -L --cookie "SCookieGUID=%guid%" --cookie "SUserID=%user%" \

> https://elibrary.ru/author_items.asp?authorid=499156 \

> | grep -Eo 'данную">[0-9]+' \

> | grep -Eo '[0-9]+' \

> | sort -nr \

> | awk 'NR <= $1 { c += 1 } END { print c }'

8

Если необходимо посчитать индекс Хирша по всем публикациям, то после входа на сайт на странице автора необходимо нажать на ссылку “Вывести на печать список публикаций автора” и разобрать HTML, содержащий все статьи автора, о которых известно научной электронной библиотеке Elibrary:

~$ open https://elibrary.ru/author_items.asp?authorid=499156

Opening in existing browser session.

~$ curl -s --cookie "SCookieGUID=%guid%" --cookie "SUserID=%user%" \

> https://elibrary.ru/author_items_print.asp \

> | grep -Eo "(</td><td align=center valign=top width=30>|<td align=center valign=top>).*</td></tr>" \

> | sed 's/width=30//' \

> | grep -Eo "[0-9]+" \

> | sort -nr \

> | awk 'NR <= $1 { c += 1 } END { print c }'

25

Здесь используется утилита sed, выполняющая поиск подстроки width=30 и её замену на пустую строку.

Реализованный конвейер показан на рис. 10:

1.6.4. Упражнения

Задача 1. Напишите однострочник для получения с помощью GitHub API сообщений всех коммитов заданного репозитория, с сохранением результатов в формате CSV.

Задача 2. Напишите однострочник для получения информации о бассейнах, имеющих ширину более 8 метров.

Задача 3. Напишите однострочник для получения информации о бассейнах, работающих в заданном диапазоне времени.

Задача 4. Доработайте однострочник для получения индекса Хирша таким образом, чтобы не было необходимости открывать страницу автора в браузере перед вычислением индекса Хирша автора по всем публикациям.

Задача 5. Напишите однострочник для вычисления g-индекса заданного автора.

1.7. Эмулятор командной оболочки Linux

1.7. Эмулятор командной оболочки Linux

В этом разделе рассмотрим процесс разработки эмулятора командной оболочки Linux на языке программирования Python. В нашем эмуляторе будут поддерживаться как простые команды, так и команды для работы с виртуальной файловой системой.

1.7.1. Простые команды

Начнём с заготовки эмулятора с поддержкой команд echo, date, exit [8], работающей в режиме REPL (Read-Eval-Print Loop, цикл «чтение – вычисление – вывод»). Перед тем, как приступить к разработке эмулятора, изучим, как работают перечисленные команды в командной оболочке Linux:

~$ echo Hello, world!

Hello, world!

~$ date

Пн 13 янв 2025 02:22:54 MSK

~$ exit

Команда echo печатает в stdout введённый пользователем текст, date позволяет получить текущую дату и время, а exit завершает выполнение процесса командной оболочки.

Создадим файл emu.py и поместим в него код, выполняющий эмуляцию указанных команд:

import time

def repl():

while True:

match input('> ').split():

case ('exit',):

return

case ('echo', *args):

print(*args)

case ('date',):

print(time.asctime())

repl()

При выполнении программы emu.py запускается бесконечный цикл while, на каждой итерации которого демонстрируется приглашение к вводу >. Команда, введённая пользователем в stdin, при помощи метода split разделяется по пробельным символам на отдельные слова.

Для распознавания команд используется структурное сопоставление с образцом [26]. Первое слово, встречающееся во введённой пользователем команде, считается её именем, а все последующие слова – аргументами. Команда exit позволяет выйти из бесконечного цикла, команда echo печатает введённые пользователем аргументы, а команда date печатает текущее время.

Сеанс работы с нашим эмулятором сейчас выглядит так:

~$ python emu.py

> echo Hello, world!

Hello, world!

> date

Mon Jan 13 02:28:33 2025

> echo Bye, world!

Bye, world!

> exit

1.7.2. Виртуальная файловая система

Теперь добавим в эмулятор поддержку работы с виртуальной файловой системой. Сначала ограничимся отображением текущей директории в приглашении к вводу и поддержкой команд cd и pwd. Простой сеанс работы с файловой системой из командной оболочки Linux может иметь вид:

~$ mkdir repo

~$ cd repo

~/repo$ mkdir src

~/repo$ cd src

~/repo/src$ pwd

/home/user/repo/src

~/repo/src$ cd ..

~/repo$ cd ..

~$ cd unknown

bash: cd: unknown: No such file or directory

~$ rm -r repo

Команда mkdir создаёт пустую папку с указанным именем, а при помощи команды cd можно изменить текущую директорию на указанную пользователем. Директория, в которой находится пользователь, отображается в приглашении к вводу [8]. Например, команда cd repo меняет текущую директорию с ~ на ~/repo, и приглашение к вводу имеет вид ~/repo$ вместо ~$. Команда pwd печатает абсолютный путь к текущей директории. Команда cd .. позволяет перейти в родительскую директорию по отношению к текущей директории. При попытке перейти в несуществующую директорию unknown в консоль выводится сообщение об ошибке.

В файловой системе Linux папка содержит только имя для каждого находящегося внутри файла, а также численный указатель на расположение файла, связанный с его именем. Этот численный указатель также известен как индексный дескриптор (inode number) [3]. Структура данных inode, связанная с этим дескриптором, содержит метаданные файла – сведения о файле, за исключением содержащихся в файле данных.

Реализуем в нашем эмуляторе упрощённую модель файловой системы Linux. Создадим класс Node, содержащий сведения о типе файла, а также связанные с файлом данные. Реализуем также команды cd и pwd и подготовим образ виртуальной файловой системы по диаграмме, показанной на рис. 11.

Обновлённая версия нашего эмулятора теперь имеет вид:

class Node:

def __init__(self, file_type, data=''):

self.file_type = file_type

self.data = data

def cd(node, name):

if name in node.data and node.data[name].file_type == 'dir':

return node.data[name]

print('No such file or directory')

return node

def pwd(node):

if par := node.data.get('..'):

for name in par.data:

if par.data[name] == node:

return pwd(par) + name + '/'

return '/'

def repl(node):

while True:

match input(f'{pwd(node)}> ').split():

case ('exit',):

return

case ('cd', name):

node = cd(node, name)

case ('pwd',):

print(pwd(node))

# Реализация команд echo, date.

src = Node('dir', {})

repo = Node('dir', {'src': src})

root = Node('dir', {'repo': repo})

src.data['..'] = repo

repo.data['..'] = root

repl(root)

На вход функции repl передаётся подготовленный образ виртуальной файловой системы. Переменная node в функции repl представляет собой директорию, в которой находится пользователь. В цикл обработки ввода была добавлена поддержка команд cd и pwd, а реализация команд echo и date осталась без изменений.

Новая команда cd в нашем эмуляторе позволяет перемещаться по файловой системе. Если аргументом команды является слово .., текущая директория node меняется на родительскую директорию. Новая команда pwd позволяет получить путь к текущей директории, в качестве разделителя фрагментов пути используется символ /. Путь к текущей директории также печатается в приглашении к вводу, как в командной оболочке Linux.

Проверим работу обновлённого эмулятора:

~$ python emu.py

/> cd repo

/repo/> cd src

/repo/src/> echo It works!

It works!

/repo/src/> pwd

/repo/src/

/repo/src/> cd ..

/repo/> cd ..

/> cd unknown

No such file or directory

/> exit

Для работы с файловой системой полезно иметь возможность создавать как папки, так и файлы – для этого в командной оболочке Linux используются команды mkdir и touch. Кроме того, нужна возможность просмотра содержимого текущей директории – для этого подойдёт команда ls [8].

Добавим в emu.py поддержку команд mkdir, touch и ls :

def mkdir(node, names):

for name in names:

node.data[name] = Node('dir', {'..': node})

def touch(node, names):

for name in names:

node.data[name] = Node('file')

def ls(node):

for name in sorted(node.data):

if name != '..':

print(name, end=' ')

print()

def repl(node):